Seaweed APT是什么

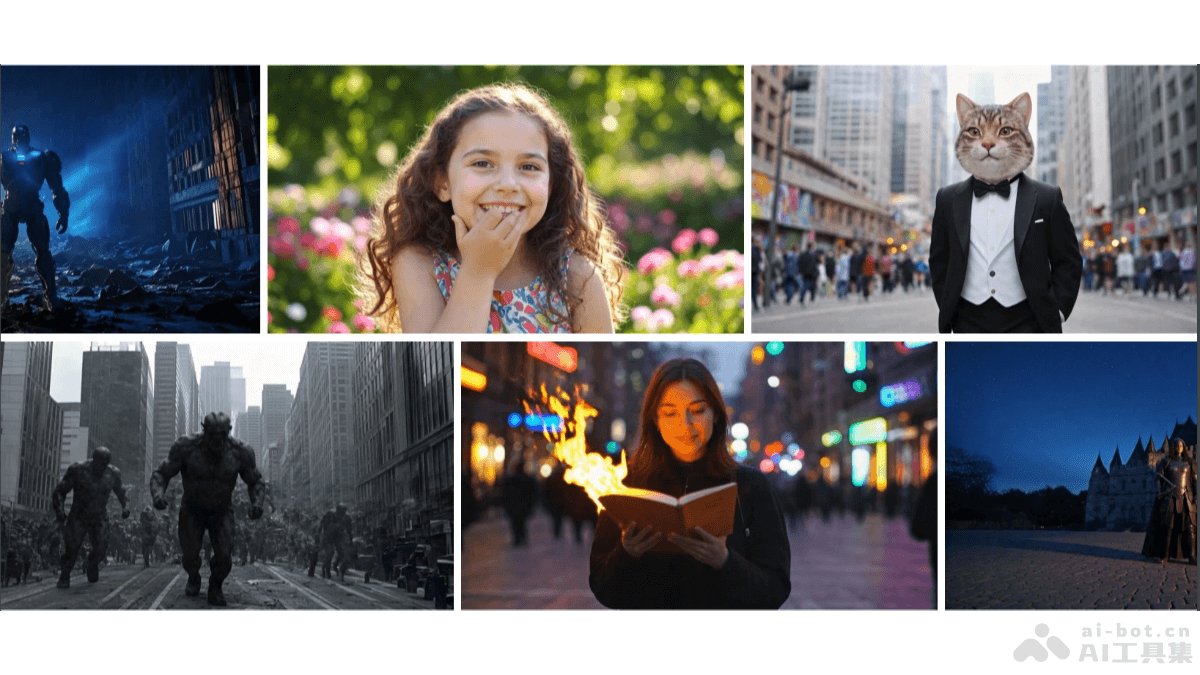

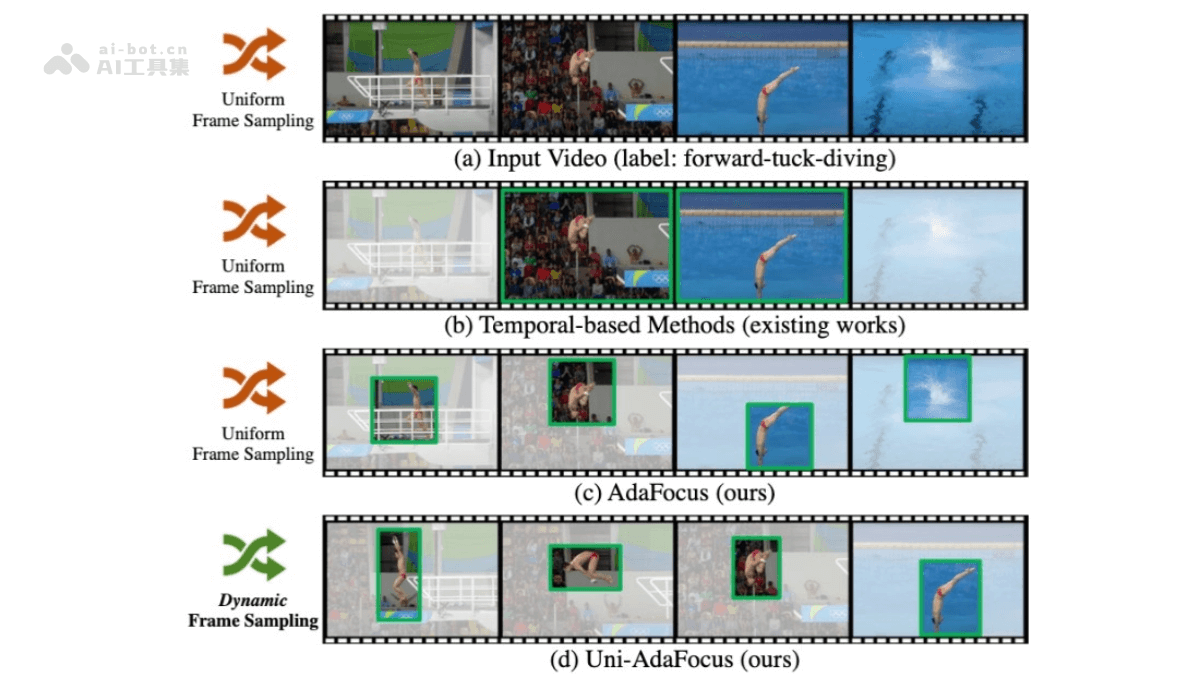

Seaweed APT是字节跳动推出的对抗性后训练(Adversarial Post-Training)模型,能实现图像和视频的一站式生成。Seaweed APT基于预训练的扩散模型,直接对真实数据进行对抗性训练,而非用预训练模型作为教师来生成目标,在单步生成中实现高质量的图像和视频输出。Seaweed APT引入多项改进,包括确定性蒸馏初始化的生成器、增强的判别器架构及近似R1正则化目标,提高训练的稳定性和生成质量。实验表明,Seaweed APT能在单步中生成1024px的图像和2秒、1280×720、24fps的视频,且在视觉保真度上超越传统的多步扩散模型。

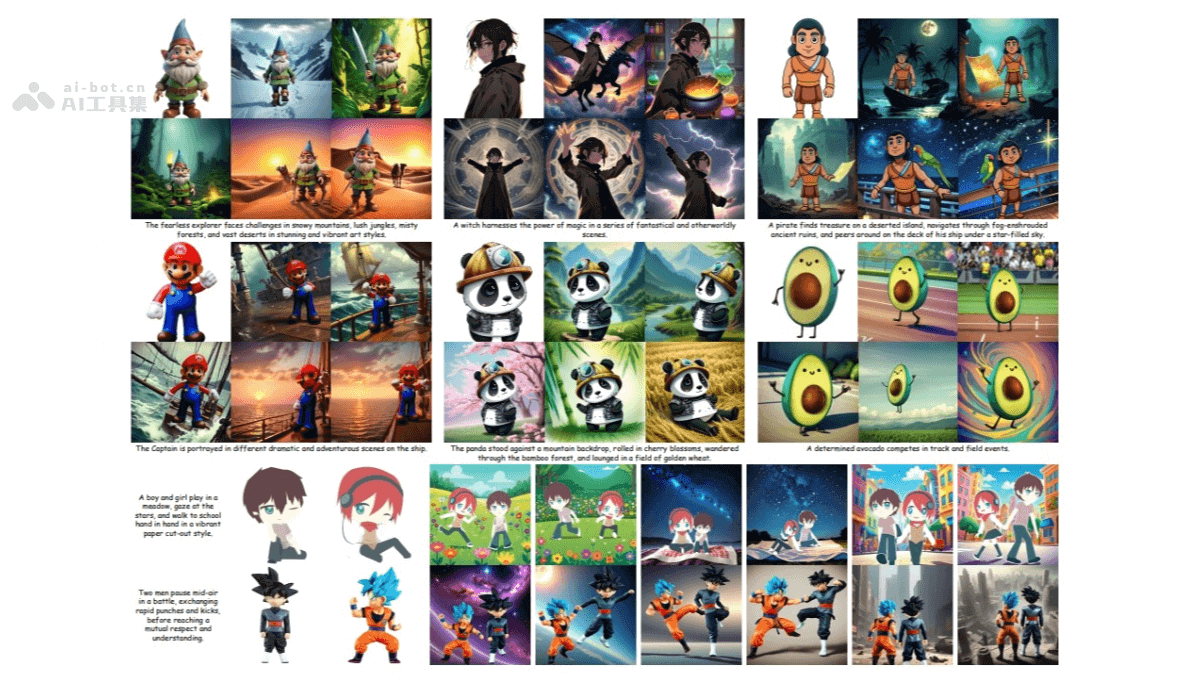

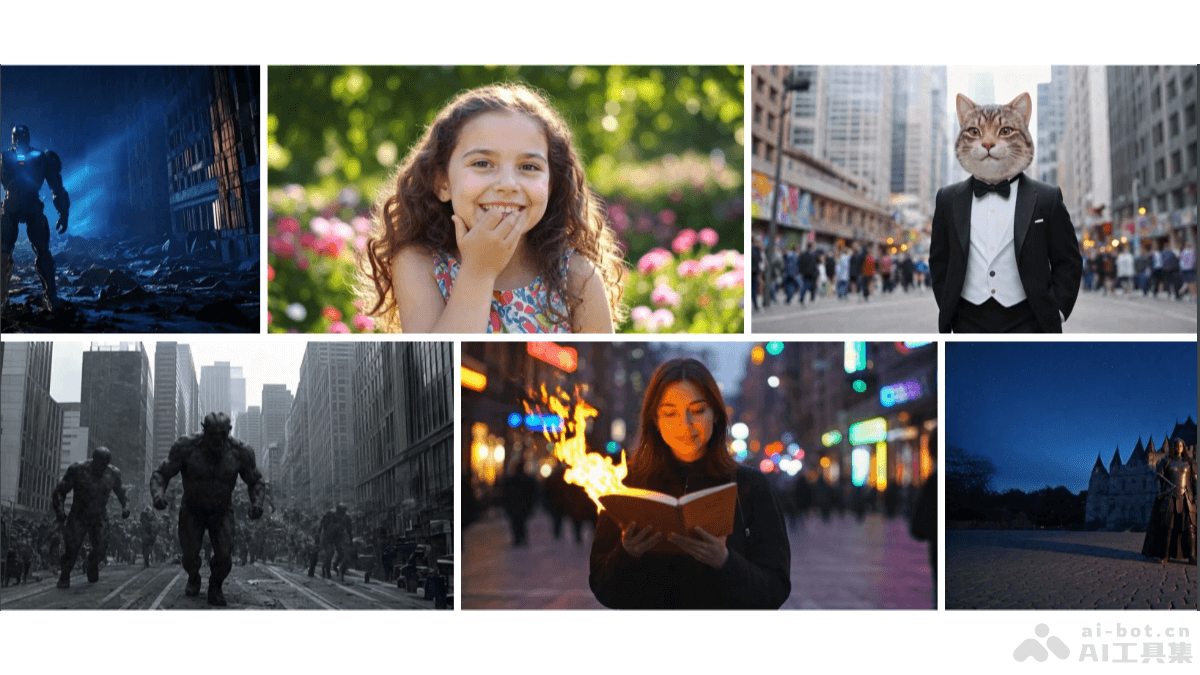

Seaweed APT的主要功能

单步高质量图像生成:能生成 1024px 分辨率的图像,且在视觉保真度、细节和结构完整性方面与多步扩散模型相当。单步高分辨率视频生成:首次实现 1280×720、24fps、2 秒长的视频生成,显著提高视频生成的效率和质量。实时生成能力:在单个 H100 GPU 上,Seaweed APT 能在 6.03 秒内生成一个 2 秒的 1280×720 24fps 视频,基于 8 个 H100 GPU 并行化,整个生成过程实现实时处理。超越预训练模型:直接在真实数据上进行对抗性训练,Seaweed APT 避免预计算视频样本的高昂成本,在某些评估标准上超越预训练的扩散模型,特别是在真实感、细节和曝光问题上。

Seaweed APT的技术原理

预训练扩散模型初始化:用预训练的扩散变换器(DiT)作为初始化,避免预计算视频样本的高昂成本,且在某些评估标准上超越预训练模型。对抗性训练:基于对抗性训练目标对真实数据进行训练,直接在真实数据上进行训练,生成更接近真实分布的样本,提高生成质量和真实感。生成器设计:采用确定性蒸馏初始化生成器,用离散时间一致性蒸馏(discrete-time consistency distillation)和均方误差损失进行初始化。生成器在训练过程中主要关注单步生成能力,始终输入最终时间步 T。判别器设计:判别器用预训练的扩散网络进行初始化,在潜空间中直接操作。判别器包含 36 层 Transformer 块,总参数量为 80 亿。基于在多个时间步引入新的交叉注意力块,判别器能更好地区分真实样本和生成样本。近似 R1 正则化:为解决大规模 Transformer 模型中 R1 正则化的高阶梯度计算问题,推出一种近似方法。在真实数据上添加小方差的高斯噪声,减少判别器在真实数据上的梯度,实现与原始 R1 正则化一致的目标。训练细节:首先在图像上进行训练,然后在视频上进行训练。用大量的 H100 GPU 和梯度累积达到较大的批量大小,提高训练的稳定性和结构完整性。采用指数移动平均(EMA)衰减率来稳定训练过程,在训练过程中调整学习率确保训练的稳定性。

Seaweed APT的项目地址

项目官网:https://seaweed-apt.comarXiv技术论文:https://arxiv.org/pdf/2501.08316

Seaweed APT的应用场景

视频广告制作:快速生成高质量、风格多样的视频广告,减少制作成本和时间。影视内容创作:为电影和电视剧生成特定风格的视频片段,提升创作效率和内容多样性。社交媒体内容:生成个性化、高质量的视频和图像,增强用户参与度和内容吸引力。游戏开发:快速生成游戏中的角色、场景和道具图像,加速游戏开发流程。教育与培训:生成教育视频和培训材料,提高教学效果和培训质量。